Tech Blog

物体検知AIモデルの軽量化

よろしくお願いします!!

突然ですが、「AIモデルの軽量化」に興味はありませんか?昨年末にご紹介した『AIモデル軽量化技術「PCAS」使ってやってみた!』では、実際の事例を交えながら、この技術がどんな可能性を広げるかを掘り下げてみました。実際、自分自身で試行錯誤しながらやってみたので、やってみたいアイデアが次々に湧き出てきたので、新しい挑戦に踏み出すことにしました!

「前回見逃しちゃった…」という方もご安心ください。以下にリンクを貼っておきますので、ぜひチェックしてみてくださいね。

では、本編スタート!

チャンスは最大限に活かす、それがボクの主義だ!

というわけで、渉さん、今回がブログの最終回とならないようにお願いしますね!!。

ブログが続くかどうかのカギはボクたち次第!特に今回は、「PCAS」を活用したAIモデル軽量化の新たな可能性を深掘りしてみようと思っているんです。

検証したいことがあるって言ってたもんな。任せてくれ!

で、どんなことを試したいんだい?

じゃあ、始めるか!

「YOLO」とは

じゃあ「YOLO v8」はどうなんですか?

他にもユニークなバージョンってあるんですか?

いろいろ迷いますが、今回は柔軟性が高く、省リソース向けとしても注目されている「YOLOX」のモデルを、『PCAS』を使って軽量化してみましょう!

いざ、軽量化!

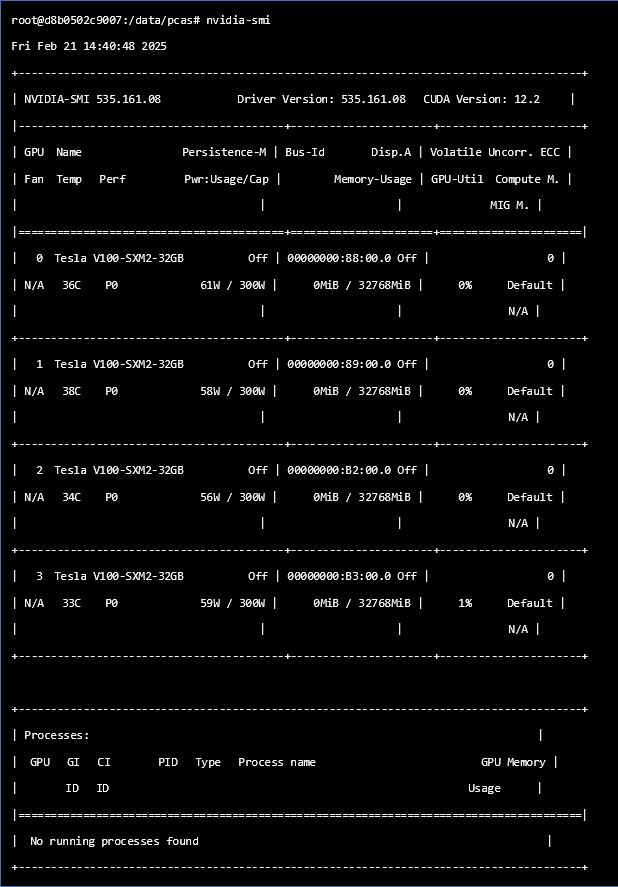

データセットがサーバーに保存されていることを確認しておいてね。

それじゃあ、実行してみますね。

ポチっとな。

python examples/detection/train_meg.py \

--outdir /path/to/output \

--data_dir /path/to/coco \

--dataset coco_meg \

--model yoloxm_meg \

--pl_module detector_meg \

--mode train \

--pcas_max_iters 6 \

--max_epochs 300 \

--learning_rate 0.01 \

--finetune_lr_ratio 0.3 \

--batch_size 8 \

--devices 4 \

数時間後…

さすがにこれは大規模すぎたようだ。

まさに「スケールが違う」挑戦だわな・・・

データを減らさないと現実的な時間で評価結果が得られませんね・・・ここは精度は多少低くなると思いますが、データセットを減らさないとですかね。

アノテーションと評価用のデータも準備完了!

もう一度ポチっとな!

3日後…

AP50がところどころ「iteration」において「0」になっていますね…。

| 軽量化実施回数 | val/AP@0.5 | 損失(Loss) | モデルサイズ(MB) |

|---|---|---|---|

| 学習 | 0 | 17.00109482 | 96.9 |

| 1回目 | 1.953125*10^-3 | 13.58625031 | 74.3 |

| 2回目 | 1.725501*10^-310 | 16.02896500 | 59.0 |

| 3回目 | 0 | 13.87439728 | 44.3 |

| 4回目 | 0 | 13.93522644 | 35.7 |

モデルサイズは確実に軽量化されています。

最後に…

あとは、スクラッチ学習時のバッチサイズをもう少し大きくするのも手かもしれません。開発環境のGPUスペックには依存するんですけど、計算効率の観点から検証する価値はあると思います。

それだけじゃなくて、まだまだ紹介しきれていない技術や、これから登場するサービスも紹介したかったのに。。。

どうです?この結果なら、続ける価値があると思いませんか?

次の展開が本当に気になります。

君たちの努力を認めましょう!

来年度4月からも、いつも通り更新を頼みます。

これからも、読者が楽しめる内容を期待しています。

ちゃんと言ってくださいよ!!でも、続けられるならやる気がまた湧いてきました。

よーし!来年度もさらに面白い記事をお届けしていきます!。

いいオチがついたな(笑)

お楽しみに!

- ※記載されている会社名、製品名は、各社の商標または登録商標です。

- ※ここに記載されている仕様、デザインなどは予告なしに変更する場合があります。